Giderek artan sayıda araç, artık yüz tanıma sistemlerinin kişisel fotoğraflarınız üzerinde alıştırma yapmasını engellemenize izin veriyor.

Yazan Will Douglas Heaven – 5 Mayıs 2021 (Çeviri: Samet Çelik)

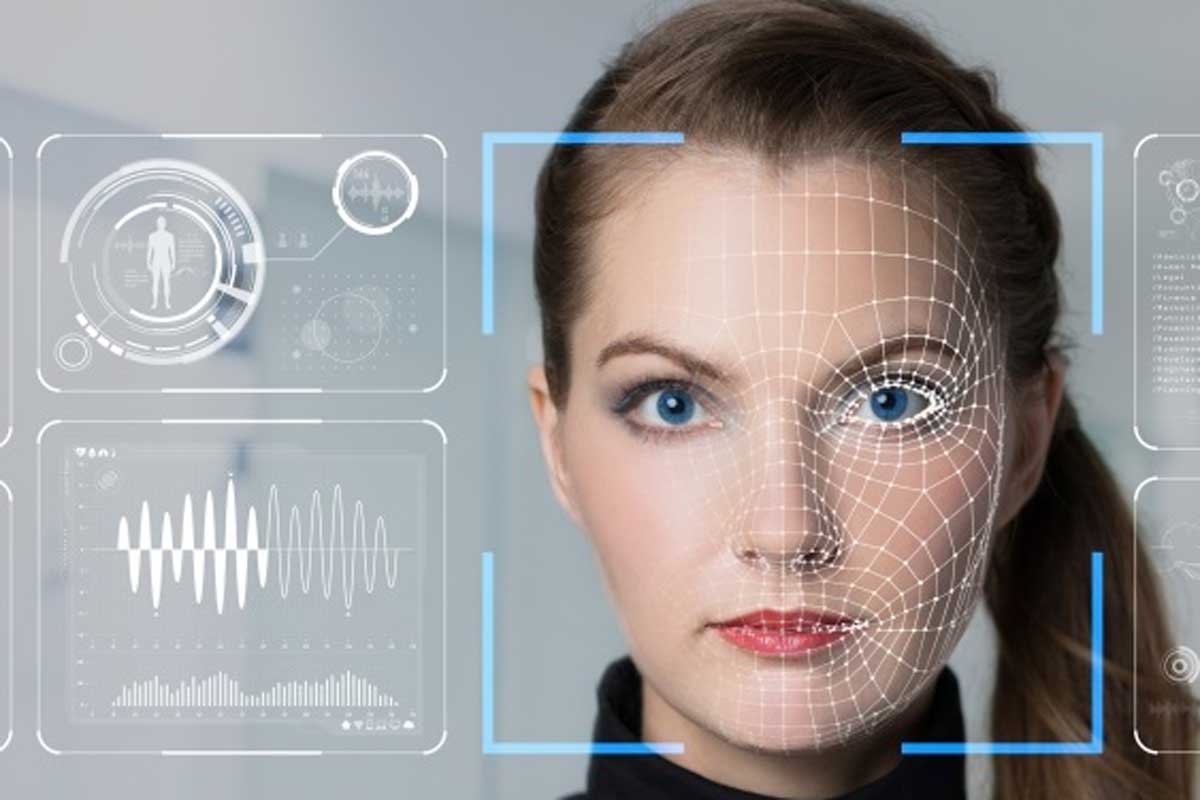

Kişisel fotoğrafları internete yüklemek, onları salıvermiş hissi uyandırabilir. Bu fotoğraflara başka kim erişebilecek, onlarla ne yapacak ve hangi makine öğrenimi algoritmalarının eğitilmesine yardımcı olacaklar?

Kişisel fotoğrafları internete yüklemek, onları salıvermiş hissi uyandırabilir. Bu fotoğraflara başka kim erişebilecek, onlarla ne yapacak ve hangi makine öğrenimi algoritmalarının eğitilmesine yardımcı olacaklar?

Clearview şirketi, ABD kolluk kuvvetlerine halka açık ağdan kazınmış milyonlarca insanın fotoğraflarıyla eğitilmiş bir yüz tanıma aracı sağladı. Ama muhtemelen bu sadece başlangıçtı. Artık temel kodlama becerilerine sahip herkes yüz tanıma yazılımı geliştirebilir; yani cinsel taciz ve ırk ayrımcılığından siyasi baskı ve dini zulme kadar, hemen her konuda teknolojiyi kötüye kullanma potansiyeli her zamankinden daha fazla.

Yüz tanıma verileriyle ilgili şimdiye kadarki en büyük çalışma, derin öğrenmenin yükselişinin ne boyutta mahremiyet kaybına yol açtığını gösteriyor. Bazı yapay zeka araştırmacıları buna başkaldırıyor ve yapay zekaların kişisel verilerden öğrenememesini sağlamak için çeşitli yollar geliştiriyor. Bu hafta son çalışmalardan iki tanesi, önde gelen bir yapay zeka konferansı olan ICLR’de sunuluyor.

Geçen yaz meslektaşlarıyla birlikte derin öğrenme algoritmalarının mahremiyet ihlali yapmalarını engelleyecek bir araç olan Fawkes’i geliştiren Chicago Üniversitesi’nden Emily Wenger, “İnsanların benden almamaları gereken şeyleri almalarından hoşlanmıyorum. Sanırım çoğumuzun aynı anda benzer bir fikri vardı.” diyor.

Veri zehirlenmesi yeni değil. Şirketlerin sizin hakkınızda sahip olduğu verileri silmeleri veya sahte örneklerle oluşturulmuş kirletici veri kümelerini kullanmaları, şirketlerin doğru makine öğrenimi modellerini eğitmesini zorlaştırabilir. Ancak bu çabaların bir etki yaratabilmesi için, tipik olarak, yüzlerce veya binlerce insanın katıldığı toplu eylemler gerekir. Bu yeni tekniklerin farkı, tek bir kişinin fotoğrafları üzerinde çalışmasıdır.

Avustralya’daki Melbourne Üniversitesi’nden Sarah Erfani, “Bu teknoloji, bir kişi tarafından verilerini kilitlemek için bir anahtar olarak kullanılabilir” diyor. “Yapay zeka çağında insanların dijital haklarını korumak için yeni bir cephe savunması bu.”

Göz önünde saklanma

Fawkes’ın da dahil olduğu araçların çoğu aynı temel yaklaşımı benimser. Bir görüntüde, insan gözünün tespit etmesi çok zor olan ama bir yapay zekayı atlatabilecek küçük değişiklikler yaparak, fotoğrafta kimi veya neyi gördüğünü yanlış tanımlamasına sebep oluyorlar. Bu teknik, girdi verilerinde yapılan küçük değişikliklerin derin öğrenme modellerini büyük hatalar yapmaya zorlayabileceği bir tür düşmanca saldırıya çok benzerdir.

Fawkes’e bir sürü selfie (özçekim / görçek) verin ve onun bu görüntülere, son teknoloji yüz tanıma sistemlerinin fotoğraflarda kimlerin olduğunu tanımlamasını engelleyecek piksel düzeyinde karışıklıklar eklemesini izleyin. Bunu yapabilen önceki yöntemlerden -yapay zeka kandırıcı yüz boyası kullanmak gibi- farklı olarak Fawkes, fotoğrafları görünürde insanları değiştirmeden bırakır.

Wenger ve meslektaşları, araçlarını Amazon’un AWS Rekognition, Microsoft Azure ve Çinli Megvii Technology tarafından geliştirilen Face++ dahil olmak üzere yaygın olarak kullanılan birkaç ticari yüz tanıma sistemine karşı test etti. 50 görüntüden oluşan bir veri setiyle yapılan küçük bir deneyde, Fawkes hepsine karşı %100 etkili oldu ve daha sonra ince ayarlı görüntülerle eğitilmiş yapay zekaların bu insanları yeni görüntülerde tanımasını engelledi. Üzerinde oynanmış eğitim görüntüleri, yapay zekaların bu insanların yüzlerini doğru şekilde tanımlamasını engellemişti.

Yeni yayınlanan epostalar, New York polisinin tartışmalı Clearview AI yüz tanıma sistemini yaygın olarak kullandığını ve bu konuda yanıltıcı açıklamalar yaptığını gösteriyor.

Fawkes, proje web sitesinden yaklaşık yarım milyon kez indirildi. Bir geliştirici aynı zamanda çevrim içi bir sürüm geliştirerek insanların kullanımını daha da kolaylaştırdı (ancak Wenger, kodu kullanan üçüncü taraflara kefil olmayarak şu uyarıyı yaptı: “Bu kişi verileri işlerken, verilerinize ne olduğunu bilemezsiniz.”). Wenger, henüz bir telefon uygulaması olmadığını, ancak birinin böyle bir uygulamayı geliştirmesini engelleyen hiçbir şey olmadığını da belirtiyor.

Fawkes, yeni bir yüz tanıma sisteminin sizi tanımasını önleyebilir -örneğin bir sonraki Clearview. Ancak önceden korumasız görüntülerinizle eğitilmiş mevcut sistemleri sabote edemez. Bununla birlikte teknoloji gelişmeye devam ediyor. Wenger, bu hafta ICLR’daki ekiplerden biri olan Maryland Üniversitesi’nden Valeriia Cherepanova ve meslektaşları tarafından geliştirilen bir aracın bu sorunu çözebileceğini düşünüyor.

Lowkey olarak adlandırılan araç, güçlü bir düşmanca saldırı yöntemini baz alıp görüntülere karışıklıklar ekleyerek Fawkes üzerinde yayılıyor. Bu da önceden eğitilmiş ticari modelleri kandırabiliyor. Fawkes gibi LowKey de çevrim içi olarak erişilebilir durumda.

Erfani ve meslektaşları daha büyük bir bükülme ekledi. Deakin Üniversitesi’nden Daniel Ma ve Melbourne ve Peking üniversitelerinden araştırmacılarla birlikte Erfani, görüntüleri “öğrenilemez örneklere” dönüştürerek yapay zekanın selfie’lerinizi tamamen yok saymasını sağlayan bir yöntem geliştirdi. Wenger, “Bence harika.” diyor. “Fawkes bir algoritmayı sizin hakkınızda yanlış şeyler öğrenmesi için eğitiyor, ama bu araç bir algoritmayı sizin hakkınızda hiçbir şey öğrenmemesi için eğitiyor.”

Erfani ve meslektaşları daha büyük bir bükülme ekledi. Deakin Üniversitesi’nden Daniel Ma ve Melbourne ve Peking üniversitelerinden araştırmacılarla birlikte Erfani, görüntüleri “öğrenilemez örneklere” dönüştürerek yapay zekanın selfie’lerinizi tamamen yok saymasını sağlayan bir yöntem geliştirdi. Wenger, “Bence harika.” diyor. “Fawkes bir algoritmayı sizin hakkınızda yanlış şeyler öğrenmesi için eğitiyor, ama bu araç bir algoritmayı sizin hakkınızda hiçbir şey öğrenmemesi için eğitiyor.”

Web’den kazınmış görüntülerim (üstte), bir yüz tanıma sisteminin görmezden geleceği, öğrenilemez örneklere (altta) dönüştürüldü. (Sarah Erfani, Daniel Ma ve meslektaşlarına teşekkür ederiz.)

Fawkes ve takipçilerinin aksine, öğrenilemeyen örnekler düşmanca saldırılara dayanmaz. Ma’nın ekibi, bir görüntüde yapay zekayı hata yapmaya zorlayan değişiklikler yapmak yerine, eğitim sırasında onu görmezden gelmesi için yapay zekayı kandıran küçük değişiklikler ekliyor. Görüntü daha sonra sunulduğunda, içinde ne olduğuna dair değerlendirmesi rastgele bir tahminden daha iyi olmayacaktır.

Öğrenilemeyen örnekler, algoritmaların eğitilmemesini sağlayacağı için, düşmanca saldırılardan daha etkili olabilir. Bir yapay zeka ne kadar çok düşmanca örnek görürse, onları tanımada o kadar iyi olur. Ancak Erfani ve meslektaşları, ilk etapta bir yapay zekanın görüntüler üzerinde eğitim almasını engellediği için bunun, öğrenilemez örnekler yöntemi ile mümkün olmayacağını iddia ediyorlar.

Gelgelelim Wenger, devam eden bir savaşta teslim oldu. Ekip kısa süre önce Microsoft Azure’un yüz tanıma hizmetinin, artık bazı görüntüleri tarafından yanıltılamadığını fark etti. “Her nasılsa oluşturduğumuz örtülü görüntülere karşı ansızın dirençli hale geldi.” diyor. “Ne olduğunu bilmiyoruz.”

Microsoft algoritmasını değiştirmiş olabilir veya yapay zeka, Fawkes kullanan insanlardan o kadar çok görüntüyle karşılaşmıştır ki onları tanımayı öğrenmiştir. Her iki durumda da Wenger’in ekibi geçen hafta araçlarında yine Azure’a karşı çalışan bir güncelleme yayınladı. Wenger, “Bu başka bir kedi-fare silahlanma yarışı” diyor.

Microsoft algoritmasını değiştirmiş olabilir veya yapay zeka, Fawkes kullanan insanlardan o kadar çok görüntüyle karşılaşmıştır ki onları tanımayı öğrenmiştir. Her iki durumda da Wenger’in ekibi geçen hafta araçlarında yine Azure’a karşı çalışan bir güncelleme yayınladı. Wenger, “Bu başka bir kedi-fare silahlanma yarışı” diyor.

Wenger için bu, internetin hikayesi. “Clearview gibi şirketler, serbestçe erişilebilen veriler olarak kabul ettikleri şeylerden yararlanıyor ve istediklerini yapmak için kullanıyorlar” diyor.

Düzenlemeler uzun vadede yardımcı olabilir, ancak bu, şirketlerin boşlukları kullanmasını engellemez. “Yasal olarak kabul edilebilir olan ile insanların gerçekte istedikleri arasında her zaman bir kopukluk olacak” diyor Wenger. “Fawkes gibi araçlar bu boşluğu dolduruyor.”

“İnsanlara daha önce sahip olmadıkları bir güç verelim” diye ekliyor.

Yazının orijinalini buradan okuyabilirsiniz.